라즈베리파이5 Ollama 모델 리뷰

본문

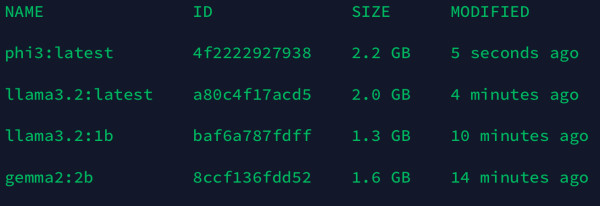

라즈베리파이5 8기가 (엑티브 쿨러 장착된 상태 + 야매 쿨링 시스템 https://zod.kr/free/293564 - 기본 온도 33도 ) - Ubuntu 24.04.1 LTS - 아이패드 ssh로 접속했을 때 (ssh 앱: termius, 온도 측정앱: ServerBox)

테스트 기준:

"뻘짓이 뭔지 설명해봐" 를 입력했을 때 cpu 사용률, 최고 온도, 램 사용량, 걸린 시간

1. Llama 3.2 1B (1.3GB)

- 설치: ollama run llama3.2:1b

- 결과:

- cpu 사용률: 98.4%

- 최고온도: 48.5도

- 램 사용률: 28%

2. Llama 3.2 3B (2GB)

- 설치: ollama run llama3.2

- 결과:

- 최고온도: 57.3도

- 램 사용률: 45%

- 걸린 시간: 약 1분 25초

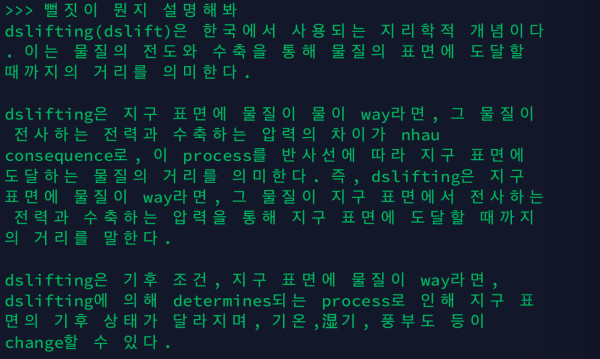

3. Phi 3 Mini 3.8B (1.6GB)

- 설치: ollama run phi3

- 결과:

- 최고온도: 59.5도

- 램 사용률: 74%

- 걸린 시간: 약 1분 27초

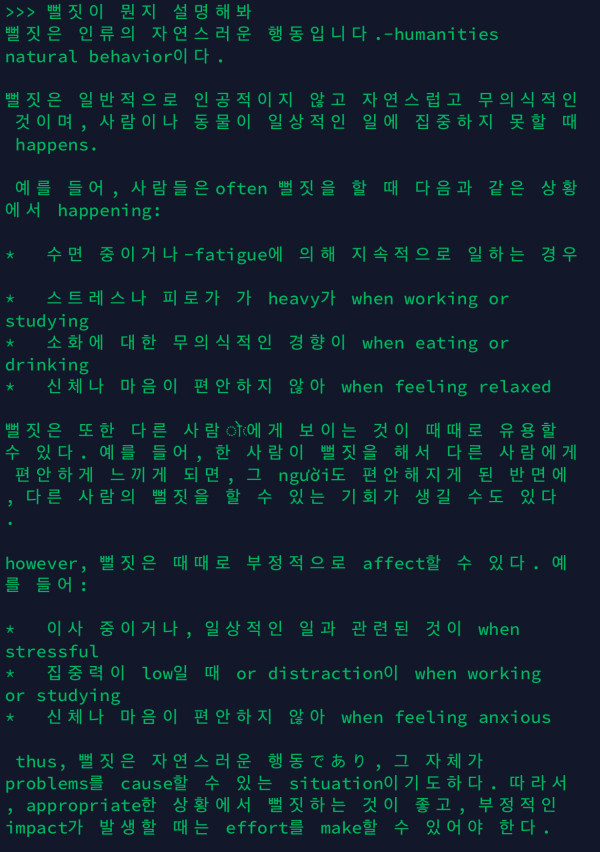

4. Gemma 2 2B (1.6GB)

- 설치: ollama run gemma2:2b

- 결과:

- 최고온도: 59도

- 램 사용률: 39%

- 걸린 시간: 약 1분 26초

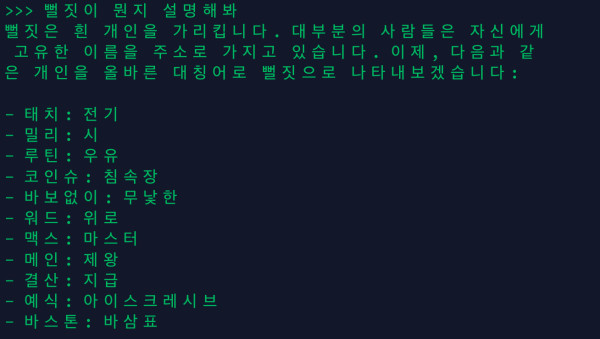

Exaone3.5 2.4b (1.6GB)

- 설치: ollama pull exaone3.5:2.4b

- 결과:

- 최고 온도: 51.3도

- 램 사용률: 36%

- 걸린 시간: 약 57초

*EXAONE 3.5는 LG AI Research에서 개발한 영어와 한국어를 지원하는 생성형 AI 모델 시리즈로, 24억 개에서 320억 개에 이르는 다양한 파라미터 규모로 구성되어 있다고하네요.

소감:

한국어로 사용할거면 굳이 쓸 이유를 모르겠음...

영어였다면 결과가 아마 유의미하게 달라졌을 것 같네요.

그래도 이렇게까지 한국어를 못하는 건 문제가 있는 것 같습니다.

Exaone가 제일 나은 느낌입니다.

라마 모델은 아래 링크에서 검색할 수 있습니다.

(공식 사이트) https://ollama.com/search

여기에서 찾은 모델들은 전부 ollama run 모델명 으로 다운로드 가능합니다.

*영어는 귀찮아서 기회가 된다면 다음번에

등록된 댓글이 없습니다.